Разные причины побуждают вебмастеров закрыть свой ресурс от поисковых роботов. Процедуру защиты от индексации или добавления страниц сайта в базы данных поисковиков, применяют, когда требуется:

- скрывать секретные сведения от общего ознакомления;

- создавать релевантный контент для улучшения позиций, большое количество информации заглушает тематику текста, которую нужно предоставить пользователю;

- закрывать, дублирующий информационный ресурс;

- делать невидимыми устаревшие материалы, мусорные страницы введут в заблуждение поисковую систему.

Запрет индексации поддомена

Каждый поддомен для поисковика — это обособленный адрес в интернете. Поэтому скрыть портал можно любым методом, разработанным для веб-страниц.

Запрет индексации отдельного блока

Часто обстоятельства требуют закрыть от индексации разные данные:

- счетчик;

- меню;

- код;

- текст.

В пик популярности Яндекса, когда в Google сайты выводилась на передние позиции сами по себе, для скрытия какой-то информации применяли тег <noindex>.

Однако со временем Яндекс перестал реагировать на применение таких технических мер, а Google вообще не понимал подобных приемов. Поэтому пришлось разрабатывать и внедрять другой механизм. Закрывать информацию от индексации стали при помощи JavaScript. Схема проста: нужный элемент кодируют, используя язык программирования JavaScript, после чего сам скрипт закрывают от индексации через robots.txt.

Для реализации схемы понадобится набор инструментов:

- HTML-код.

- Файо robots.txt.

- Jquery.

- SEOhide.js.

- Файл BASE64.js

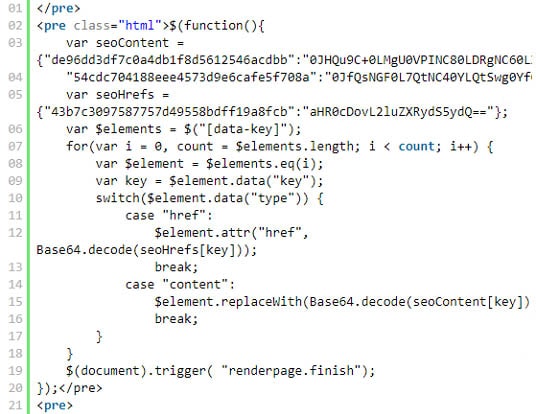

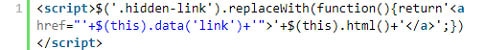

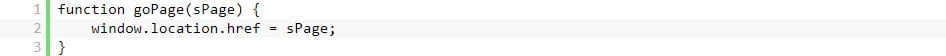

Сам код выглядит так.

Где:

- seoContent — переменная, в которую записывается html-код.

- seoHrefs — переменная, в которую записывают ссылки.

- de96dd3df7c0a4db1f8d5612546acdbb — идентификатор для замены.

- 0JHQu9C+0LMgU0VPINC80LDRgNC60LXRgtC+0LvQvtCz0LAgLSDQn9Cw0LLQu9CwINCc0LDQu9GM0YbQtdCy0LAu – html-код для идентификатора.

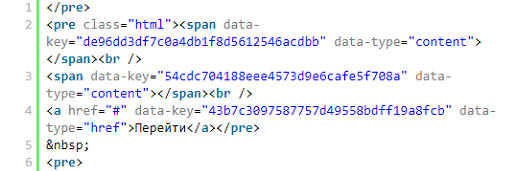

Содержание HTML:

В конце важно не забыть скрыть SEOhide.js в файле robots.txt

Запрет индексации страниц

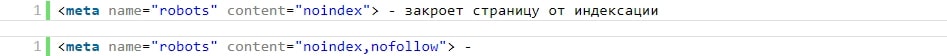

Есть несколько вариантов, чтобы закрыть страницу от индексации:

- При помощи файла robots.txt.

- С использованием на нужной странице метатегов.

Совмещенный вариант:

- Запрет индексации через настройку ответа сервера. Например, «ErrorDocument 404 http://site.ru/404» — выдаст ошибку страницы. Если вписать код 410 — что страница удалена,

Данный способ не совсем «белый» и применяется только в крайних случаях

Запрет индексации изображений

Когда контент содержит не уникальные картинки, существует угроза негативной реакции со стороны поисковых систем. В данном случае код элемента будет выглядеть так:

Обработает элемент следующий скрипт:

Запрет индексации дублей

Существует 5 способов, как сделать невидимыми страницы с одинаковым контентом:

- Самый правильный способ — сразу удалить всю лишнюю информацию, чтобы остались только оригинальные источники. На остальные сервер будет отвечать ошибкой 404.

- При помощи файла robots.txt — самый простой способ.

- Метатеги для каждой дублирующей страницы.

- Сделать 301 редирект в файле .htaccess с дублей на оригиналы.

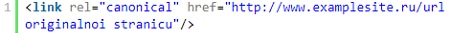

- Тег rel=»canonical» — второй по правильности способ. Во-первых, этот тег запрещает поисковикам индексировать дубли, во-вторых, он передаст вес на оригиналы с дублей.

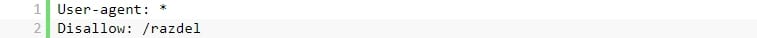

Запрет индексации раздела

Вообще самый распространенный вариант — при помощи файла robots.txt. Но это не гарантирует 100% результата. В некоторых случаях поисковые системы игнорируют запреты. В robots.txt прописывают следующие строки:

Также можно применять способы, подходящие для запрета индексации страницы, но с единственной оговоркой, что они должны применяться для всех страниц раздела. Предпочтительнее использовать вариант с метатегами на страницах-дублях или настроить код ответа сервера для всех страниц в разделе.

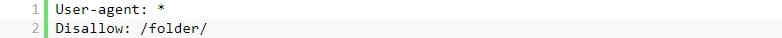

Запрет индексации папки

В папке может находиться разная информация – текстовые документы, фотографии, графические изображения и другие файлы, которые нуждаются в закрытии от поисковиков. Здесь может помочь только файл robots.txt.

Запрет индексации ссылок

Может потребоваться, чтобы уменьшить вес конкретной страницы сайта или чтобы не передавать вес сторонним ресурсам. Для закрытия страницы от индексации необходимо создать файл с названием «transfers.js» и добавить в него следующие строки:

Затем поместить данный файл в заранее созданную папку, и подключить скрипт в head на странице, где нужно скрыть ссылку от индексации:

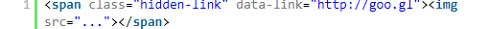

Так выглядит ссылка, которую скрывают от индексации:

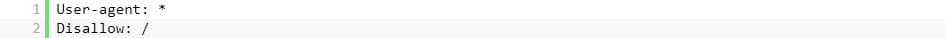

Запрет индексации сайта через robots.txt

В файле robots.txt прописываются следующие строки:

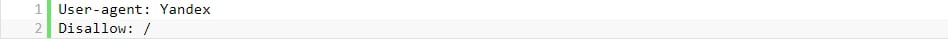

Если нужно закрыть только от Яндекса:

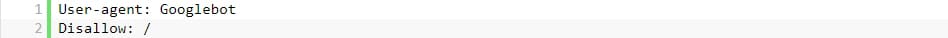

Если нужно закрыть только от Гугла:

Запрет индексации сайта через .htaccess

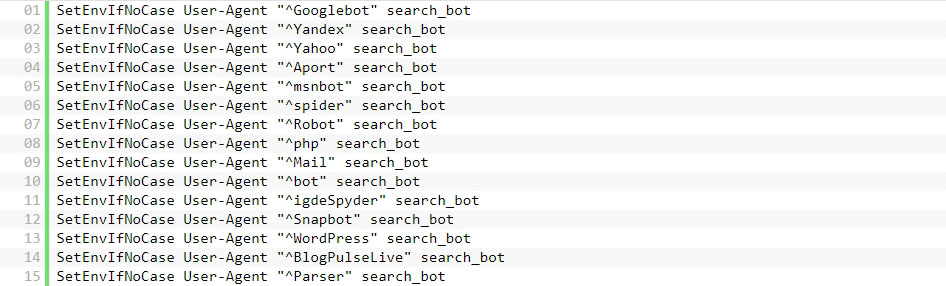

- Способ №1. Прописать в файле .htaccess следующие строки, каждая из которых отвечает за отдельную поисковую систему:

- Способ №2. В файле .htaccess прописать ответ сервера 403 (доступ к контенту запрещен) при обращении к какой-то конкретной странице.

- Способ №3. Прописать ответ сервера 410 (информация окончательно удалена).

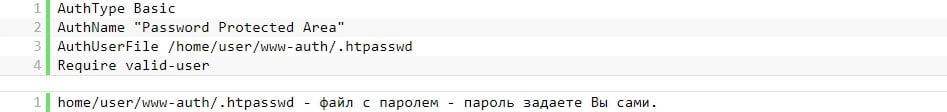

- Способ №4. Запретить индексацию, предоставив доступ к сайту только при помощи пароля. для этого в файл .htaccess добавляют следующие строки:

После добавления этих строк авторизация появится на сайте, но для того, чтобы она работала, в файл пароля необходимо добавить пользователя.

Вместо Username нужно указать собственное значение — это имя пользователя для авторизации на сайте